Активация векторов – важный этап в обработке естественного языка и машинном обучении. От выбора подходящего метода активации зависит эффективность работы нейронных сетей и качество получаемых результатов. Существует множество методов активации, каждый из которых имеет свои преимущества и особенности.

Процесс активации векторов – это некий преобразование входных данных с целью получения нелинейных выходных значений. Как правило, данный процесс применяется после нахождения взвешенной суммы входных значений. Выбор правильного метода активации важен для успешного обучения нейронной сети и достижения высокой точности предсказаний.

В данной статье мы рассмотрим несколько из лучших методов активации векторов и их применение в различных задачах машинного обучения. Мы разберем особенности каждого метода, плюсы и минусы и дадим советы по их выбору в конкретных ситуациях. Приготовьтесь узнать все о том, как выбрать подходящий метод активации для вашей нейронной сети и повысить ее эффективность!

Основные принципы активации векторов

Активация векторов в нейронных сетях играет важную роль в обучении моделей и получении качественных результатов. Для успешной активации необходимо учитывать несколько основных принципов:

| 1. | Использование функций активации |

| 2. | Подбор оптимальных параметров |

| 3. | Использование правильных инициализаций весов |

| 4. | Применение регуляризации при необходимости |

Соблюдение этих принципов позволит эффективно активировать векторы и повысить качество работы нейронных сетей.

Методы достижения высокой эффективности

Другим методом является fine-tuning, когда предобученные модели адаптируются к конкретной задаче. Этот подход позволяет значительно ускорить обучение и повысить точность результатов.

Для достижения высокой эффективности активации векторов также важно правильно настраивать параметры модели, подбирать оптимальные гиперпараметры и проводить тщательный анализ результатов обучения.

Кроме того, эффективность активации векторов может быть повышена путем использования аугментации данных, регуляризации модели и оптимизации процесса обучения.

Техники организации процесса активации

1. Принцип постепенного увеличения сложности

Для эффективной активации векторов стоит начинать с простых заданий и постепенно усложнять их. Это поможет участникам освоить базовые навыки и гладко переходить к более сложным задачам.

2. Использование игровых элементов

Игровой подход позволяет сделать активацию более увлекательной и интересной. Используйте игры, конкурсы и задачи с элементами соревнования для поддержания мотивации участников.

3. Интерактивный подход

Вовлечение участников в процесс активации путем обсуждения, анализа и обмена мнениями способствует лучшему усвоению материала. Создайте возможности для диалога и общения между участниками.

4. Индивидуальный подход

Учитывайте индивидуальные особенности участников при организации активации. Предлагайте разнообразные методы работы, чтобы каждый чувствовал себя комфортно и мог лучше взаимодействовать с материалом.

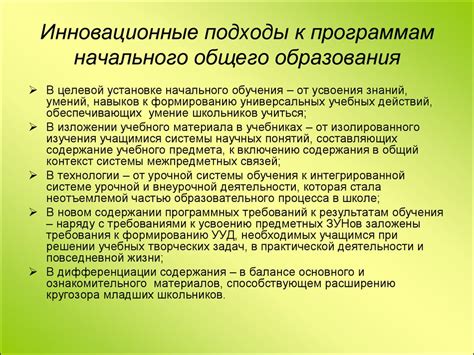

Инновационные подходы к активации векторов

1. Генеративно-состязательные сети (GAN)

Одним из самых эффективных и инновационных подходов к активации векторов являются генеративно-состязательные сети. Этот метод позволяет обучать модели для генерации реалистичных данных, расширяя спектр возможностей векторных представлений.

2. Трансформеры

Трансформеры - это мощные модели, применяемые в задачах обработки естественного языка и машинного перевода. Используя механизм внимания, они активно работают с векторами, что расширяет возможности активации и преобразования данных.

3. Рекуррентные нейронные сети (RNN)

Рекуррентные нейронные сети широко применяются в задачах последовательностей данных. Их способность к запоминанию последовательных зависимостей делает их важными инструментами для работы с векторами и их активацией.

Эффективное использование технологий

Использование специализированных библиотек и фреймворков позволяет сократить время обработки данных и повысить качество результатов. Например, библиотеки для работы с векторами, такие как NumPy и TensorFlow, обеспечивают высокую производительность и точность вычислений.

Автоматизация процессов с помощью скриптов и пакетов позволяет ускорить работу с данными и снизить вероятность ошибок. Например, использование скриптов на языке Python для автоматической предобработки данных может значительно упростить процесс работы с векторами.

Таким образом, эффективное использование технологий играет ключевую роль в успешной активации векторов и позволяет получить более точные и надежные результаты в работе с данными.

Современные стратегии работы с векторами

В современных задачах машинного обучения и глубокого обучения активация векторов играет ключевую роль. Для эффективной работы с векторами стоит обращать внимание на такие стратегии:

1. Нормализация векторов: приведение векторов к единичной длине помогает улучшить сходимость и стабильность обучения модели.

2. Использование функций активации: выбор правильной функции активации, такой как ReLU, Sigmoid или Tanh, может значительно повлиять на производительность модели.

3. Регуляризация: применение методов регуляризации, таких как L1 или L2 регуляризация, помогает предотвратить переобучение и улучшить обобщающую способность модели.

Эффективная работа с векторами включает в себя комбинацию перечисленных стратегий и постоянное экспериментирование для достижения оптимальных результатов.

Вопрос-ответ

Какие методы считаются лучшими для активации векторов?

Существует несколько популярных методов активации векторов в нейронных сетях. Среди них можно выделить такие как ReLU (Rectified Linear Activation), Sigmoid, Tanh и другие. Каждый из этих методов имеет свои особенности и применяется в зависимости от конкретной задачи.

Что такое ReLU и в чем его преимущества?

ReLU (Rectified Linear Activation) - это один из наиболее популярных методов активации векторов в нейронных сетях. Его основным преимуществом является простота вычисления и отсутствие проблемы исчезающего градиента. ReLU позволяет эффективно обучать глубокие нейронные сети и часто применяется в современных моделях.

Какой метод активации лучше использовать в задачах с высокой нелинейностью?

В задачах с высокой нелинейностью часто предпочитают использовать метод активации ReLU (Rectified Linear Activation). Этот метод хорошо справляется с нелинейными зависимостями и обладает высокой эффективностью при обучении глубоких нейронных сетей.

Какие методы активации наиболее устойчивы к проблеме затухающих градиентов?

Методы активации, такие как ReLU (Rectified Linear Activation) и его модификации, обычно считаются наиболее устойчивыми к проблеме затухающих градиентов. Это связано с их линейной природой на определенных участках и отсутствием насыщения, что позволяет избежать проблемы исчезающего градиента.

Какой метод активации чаще всего применяется в сверточных нейронных сетях?

В сверточных нейронных сетях часто применяется метод активации ReLU (Rectified Linear Activation) благодаря его хорошей эффективности и простоте вычисления. ReLU широко используется в сверточных слоях для извлечения признаков из изображений и других типов данных.